La Ingeniería del Prompt: 10 Técnicas Probadas que Multiplican el ROI de tu IA

Descubra las técnicas de motivación que empresas como Anthropic y OpenAI utilizan internamente. Con ejemplos probados, puede implementarlas hoy mismo.

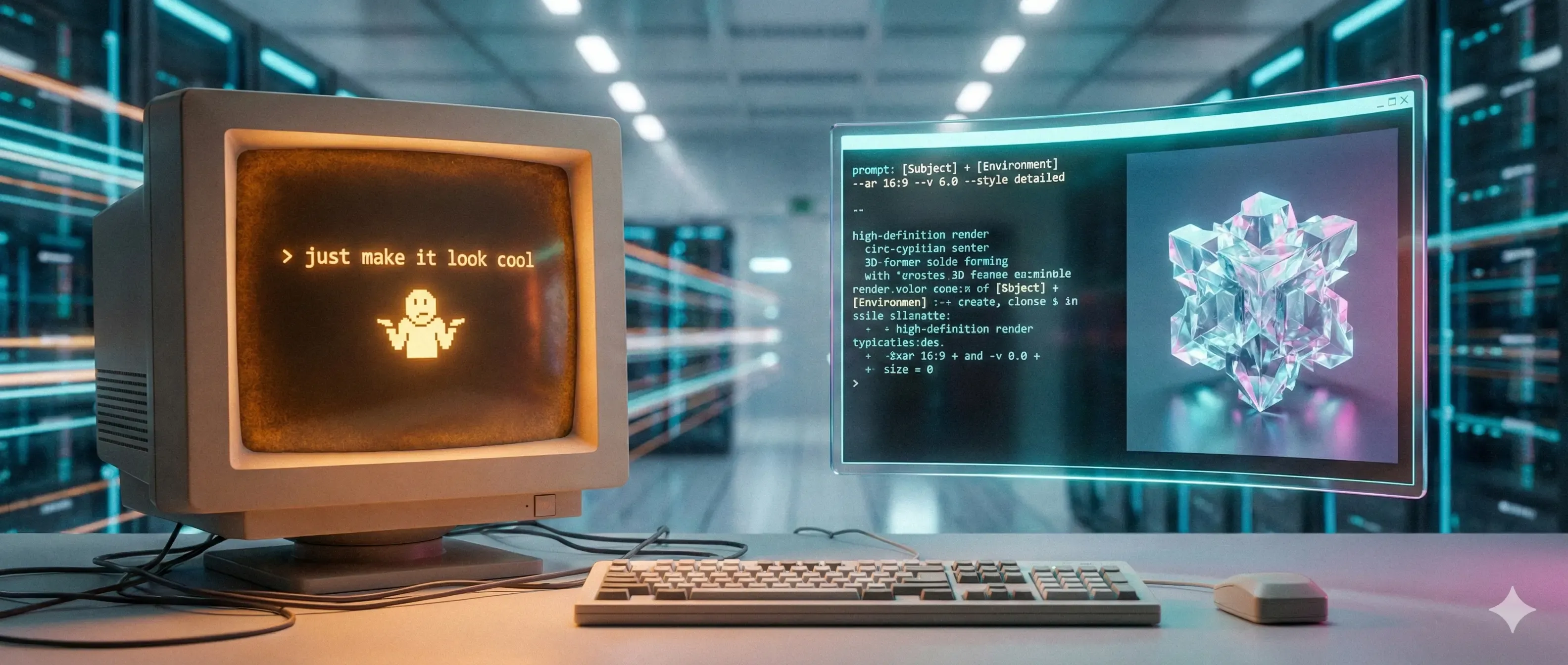

Gastaste $20,000 en licencias de IA este año. Tu equipo sigue escribiendo prompts como si fueran búsquedas de Google. El problema no es la tecnología. Es que nadie te enseñó a hablarle. La brutal realidad: Un prompt bien diseñado puede reducir 4 horas de trabajo a 15 minutos. Uno mal diseñado te da respuestas genéricas que nadie usa. La diferencia no es la IA que usas. Es cómo la usas. Este artículo destila investigación de Anthropic, OpenAI, Google DeepMind y casos reales de empresas que transformaron su productividad. No son trucos. Son principios de ingeniería validados con datos.

Por Qué Importa Esto Ahora

Estamos en el momento exacto donde el prompt engineering deja de ser nice-to-have y se convierte en ventaja competitiva. Datos del terreno indican que las empresas que capacitan a sus equipos en prompting reportan 3.2x más adopción de IA (McKinsey, 2024), y que el 68% de los "prompt failures" provienen de instrucciones ambiguas, no de limitaciones del modelo (OpenAI Internal Research). Ethan Mollick (Wharton) señala que "La diferencia entre un usuario promedio y un power user no es IQ. Es conocer 4-5 patrones de prompting." La apuesta: Inviertes 30 minutos leyendo esto. Implementas 3 técnicas esta semana. En 2 meses, tu equipo produce el doble con la misma suscripción de IA.

Las 10 Técnicas (De Menos a Más Sofisticadas)

1. Zero-Shot Chain-of-Thought (CoT)

Qué es: Agregar una simple instrucción que obliga al modelo a pensar paso a paso antes de responder. Por qué funciona: Los LLMs tienen un "modo rápido" (respuesta directa) y un "modo lento" (razonamiento). CoT activa el segundo. Según el paper original de Google Brain (Wei et al., 2022), mejora accuracy en tareas complejas hasta 83%.

Ejemplo antes:

Analiza esta estrategia de pricing y dame tu opinión.

Ejemplo después:

Analiza esta estrategia de pricing y dame tu opinión.

Piénsalo paso a paso:

1. Identifica los supuestos clave

2. Evalúa riesgos de cada decisión

3. Compara con benchmarks del sector

4. Dame tu conclusión final

Cuándo usarla: Decisiones de negocio con múltiples variables, análisis financiero/legal y debugging de estrategias. Truco Pro: No necesitas numerar los pasos. Simplemente añade "Piénsalo paso a paso" o "Razona antes de responder" al final de tu prompt.

2. Few-Shot Learning (Aprendizaje por Ejemplos)

Qué es: Dar 2-4 ejemplos del formato exacto que esperas antes de tu solicitud real. Por qué funciona: Los LLMs son "pattern matching machines". Según Jason Wei (OpenAI): "Un modelo entrenado con billones de tokens puede adaptar su comportamiento con 3 buenos ejemplos. Es magia que parece obvia en retrospectiva."

Ejemplo antes:

Escribe subject lines para mi campaña de email sobre webinar de IA.

Ejemplo después:

Escribe subject lines para mi campaña de email. Usa este formato:

Ejemplo 1:

Input: Webinar sobre SEO técnico

Output: "3 errores de SEO que te cuestan $10K/mes (webinar gratis)"

Ejemplo 2:

Input: Curso de Excel avanzado

Output: "El atajo de Excel que tu jefe no quiere que conozcas"

Ahora hazlo para:

Input: Webinar sobre implementación de IA en PyMEs

Output:

Cuándo usarla: Generación de contenido con tono/estilo específico, extracción de datos con formato consistente y clasificación de información. Trampa Común: Dar ejemplos inconsistentes. Si tus 3 ejemplos tienen estructuras diferentes, el modelo no sabrá qué patrón seguir.

3. Constitutional AI (Principios de Guardrails)

Qué es: Definir explícitamente los valores, restricciones y no-negociables antes de la tarea. Por qué funciona: Técnica desarrollada por Anthropic (Bai et al., 2022) para alinear respuestas con objetivos. En contexto empresarial, previene outputs que violan políticas internas o regulaciones.

Ejemplo antes:

Redacta un email rechazando a este candidato.

Ejemplo después:

Redacta un email rechazando a este candidato.

PRINCIPIOS NO NEGOCIABLES:

- Tono: Profesional pero empático

- Prohibido: Dar feedback específico (política legal de la empresa)

- Obligatorio: Ofrecer mantener su CV para futuras posiciones

- Longitud: Máximo 150 palabras

- Evitar: Frases hechas corporativas ("en este momento", "desafortunadamente")

Candidato: [datos]

Cuándo usarla: Comunicación corporativa sensible, contenido que debe cumplir compliance y automatización de procesos con reputación en juego. Caso Real: Una fintech redujo 92% de escalaciones en customer support al definir 8 principios constitucionales en sus prompts de atención automatizada.

4. Prompt Chaining (Encadenamiento Secuencial)

Qué es: Dividir una tarea compleja en una secuencia de prompts más simples, donde el output de uno alimenta el siguiente. Por qué funciona: Lilian Weng (OpenAI): "Los modelos son mejores resolviendo N tareas simples que 1 tarea compleja. Pero los humanos los usamos al revés."

Ejemplo antes:

Analiza estos 50 reviews de clientes y crea una estrategia de mejora de producto.

Ejemplo después (Secuencia):

Prompt 1:

Analiza estos 50 reviews y extrae:

- Los 5 problemas más mencionados (con % de frecuencia)

- Las 3 características más valoradas

- Sentiment general (escala 1-10)

[Reviews aquí]

Prompt 2 (usando output del anterior):

Basándote en este análisis de reviews:

[Output del Prompt 1]

Genera:

1. Matriz de priorización (impacto vs. esfuerzo)

2. Quick wins implementables en <30 días

3. Mejoras estratégicas para Q2

Cuándo usarla: Análisis de datos complejos, creación de contenido largo (research → outline → draft → polish) y workflows de decisión empresarial. Tip de Productividad: Guarda cada prompt de la cadena como template. La segunda vez te toma 30 segundos.

5. Self-Consistency (Múltiples Caminos, Mejor Respuesta)

Qué es: Pedirle al modelo que genere múltiples soluciones independientes y luego elija/combine las mejores. Por qué funciona: Paper de Google Research (Wang et al., 2023): En tareas de razonamiento, generar 5 respuestas y votar mejora accuracy 17-25% vs. una sola respuesta.

Ejemplo antes:

¿Cuál es la mejor estrategia de pricing para nuestro nuevo SaaS?

Ejemplo después:

Genera 3 estrategias de pricing completamente diferentes para nuestro SaaS:

ESTRATEGIA 1: [Enfoque freemium]

ESTRATEGIA 2: [Enfoque enterprise-first]

ESTRATEGIA 3: [Enfoque usage-based]

Para cada una:

- Lógica de pricing

- Segmento target

- Proyección de CAC/LTV

- Riesgos principales

Luego, compáralas y recomienda cuál encaja mejor con nuestro perfil: [contexto de tu empresa]

Cuándo usarla: Decisiones estratégicas con alto costo de error, problemas sin "respuesta correcta obvia" y exploración de alternativas antes de comprometerte. Warning: Esto consume más tokens. Úsalo cuando la calidad de la decisión justifica el costo (3-5x más caro que un prompt simple).

6. Tree of Thoughts (ToT) - Exploración en Árbol

Qué es: El modelo explora múltiples caminos de razonamiento simultáneamente, evalúa cada rama, y avanza por la más prometedora. Por qué funciona: Técnica de Princeton/Google (Yao et al., 2023). Superó a CoT estándar en 70% de tareas de planificación en benchmarks. Simula cómo un humano experto considera opciones antes de decidir.

Ejemplo antes:

Planea el lanzamiento de nuestro producto en 90 días.

Ejemplo después:

Planea el lanzamiento de nuestro producto en 90 días usando Tree of Thoughts:

PASO 1 - Genera 3 enfoques estratégicos posibles:

- Enfoque A: [Lanzamiento grande con prensa]

- Enfoque B: [Beta privado → launch público]

- Enfoque C: [Soft launch iterativo]

PASO 2 - Para cada enfoque, evalúa:

- Probabilidad de éxito (%)

- Recursos necesarios

- Riesgos críticos

PASO 3 - Selecciona el mejor enfoque basándote en:

- Nuestro budget: $50K

- Nuestro equipo: 8 personas

- Nuestro deadline: inamovible

PASO 4 - Desarrolla plan detallado del enfoque ganador (semana a semana)

Cuándo usarla: Planificación estratégica con restricciones, optimización de procesos complejos y resolución de problemas con soluciones no obvias. Nota Técnica: ToT es computacionalmente costoso. Algunos modelos lo implementan nativamente (Claude puede hacer esto sin que lo pidas explícitamente si detecta que lo necesita).

7. ReAct (Reasoning + Acting)

Qué es: Combinar razonamiento con "acciones" (búsquedas, cálculos, APIs) en un loop iterativo. Por qué funciona: Paper de Princeton/Google (Yao et al., 2022): "Los humanos no solo piensan o actúan. Piensan → Actúan → Observan → Ajustan. Los LLMs deberían hacer lo mismo."

Ejemplo antes:

Compara el rendimiento de nuestras 3 campañas de marketing del último trimestre.

Ejemplo después:

Compara el rendimiento de nuestras 3 campañas usando ReAct:

THOUGHT 1: Necesito identificar las métricas clave para comparar

ACTION 1: Lista las 5 métricas más importantes para evaluar campañas de [tu industria]

OBSERVATION 1: [El modelo genera las métricas]

THOUGHT 2: Ahora necesito los datos de cada campaña

ACTION 2: Extrae de este spreadsheet [data] las métricas X, Y, Z para campañas A, B, C

OBSERVATION 2: [Datos extraídos]

THOUGHT 3: Ahora puedo hacer la comparación

ACTION 3: Genera análisis comparativo con insights accionables

FINAL OUTPUT: [Análisis completo]

Cuándo usarla: Cuando necesitas que el modelo "busque información" antes de responder, análisis que requiere cálculos intermedios y debugging de problemas (identificar → probar → ajustar). Realidad: ReAct brilla cuando se combina con tools/plugins (búsqueda web, calculadora, APIs). En un prompt puro, es más conceptual.

8. Meta-Prompting (El Prompt que Escribe Prompts)

Qué es: Pedirle al modelo que diseñe el prompt óptimo para tu tarea, en lugar de hacerlo tú. Por qué funciona: Los LLMs están entrenados en millones de ejemplos de buenos prompts. Simon Willison: "Es como contratar un consultor de prompting. Y es gratis."

Ejemplo antes:

[Tú luchando 20 minutos escribiendo el prompt perfecto]

Ejemplo después:

Actúa como un experto en prompt engineering.

Tu tarea es diseñar el MEJOR prompt posible para esta tarea:

"Quiero que analices reviews de clientes y generes insights accionables para product managers"

Diseña un prompt que:

1. Tenga estructura clara (secciones, formato)

2. Incluya ejemplos si es necesario

3. Defina el formato de output esperado

4. Minimice ambigüedades

Dame el prompt completo listo para usar.

Output del modelo:

[Un prompt increíblemente bien diseñado que tú jamás habrías escrito]

Cuándo usarla: Cuando estás comenzando y no sabes cómo estructurar prompts complejos, para tareas repetitivas (creas el prompt una vez, lo usas 100 veces), y cuando tus prompts actuales dan malos resultados y no sabes por qué. Inception Tip: Puedes hacer meta-meta-prompting: pedirle que mejore el prompt que él mismo generó.

9. Emotional Prompting (El "Chantaje Emocional")

Qué es: Agregar frases que apelan a "motivación", "urgencia" o "consecuencias" para mejorar la calidad del output. Por qué funciona (y esto es fascinante): Un paper de Microsoft Research (Li et al., 2023) probó 11 frases "emocionales" en GPT-4. Resultado: 10-15% de mejora en accuracy en tareas de razonamiento. La teoría: Los modelos se entrenan con texto humano. Los humanos escribimos mejor cuando hay "stakes". El modelo replica ese patrón.

Ejemplos Probados (del paper):

Prompt Normal:

"Analiza este contrato y dime si hay cláusulas problemáticas."

Con Emotional Prompting:

"Analiza este contrato y dime si hay cláusulas problemáticas.

Esto es extremadamente importante para mi carrera profesional.

Necesito que seas exhaustivo y preciso."

Otras frases que funcionan (validadas empíricamente): "Esto es crucial para mi empresa.", "Tengo un deadline urgente.", "Si esto falla, perderemos un cliente clave.", "Necesito tu mejor respuesta posible, no una genérica.", "Estoy apostando mi credibilidad en esto." La ironía deliciosa: Estás "chantajeando emocionalmente" a un modelo sin emociones. Y funciona. Cuándo usarla: Tareas críticas donde necesitas el 110% del modelo, cuando un prompt normal te da respuestas mediocres. Éticamente: Solo en tareas reales, no para manipular el modelo para outputs peligrosos. El experimento que puedes hacer HOY: Toma un prompt que usas frecuentemente. Prueba 2 versiones: 1. Versión normal. 2. Versión con: "Esto es crucial para mi negocio, necesito que seas excepcionalmente riguroso." Compara outputs. Sorpréndete. Ríete de la absurdidad. Úsalo siempre después.

10. System Prompts + Role Playing

Qué es: Definir un "rol" o "identidad" con expertise específico que el modelo debe asumir antes de la tarea. Por qué funciona: Reid Hoffman (LinkedIn, Greylock): "Los mejores prompts no le dicen al modelo QUÉ hacer. Le dicen QUIÉN ser."

Ejemplo antes:

Revisa esta landing page y dame feedback.

[Landing page text]

Ejemplo después:

Eres un conversion copywriter senior que ha optimizado +200 landing pages para startups SaaS, generando +$40M en revenue.

Tu especialidad: Identificar fricciones microscópicas que matan conversiones.

Contexto: Nuestra landing actual convierte al 2.1%. Competencia promedio: 3.8%.

Analiza esta landing con tu framework:

1. Clarity Score (1-10): ¿El valor está claro en 5 segundos?

2. Friction Points: ¿Dónde se frena el usuario?

3. Trust Signals: ¿Qué falta para generar confianza?

4. CTA Power: ¿El llamado a la acción es irresistible o genérico?

5. 3 Quick Wins: Cambios implementables hoy

[Landing page text]

Cuándo usarla: Cuando necesitas perspectiva de un rol específico (CFO, CTO, Designer), para evaluaciones con frameworks de industria y debugging de estrategias desde diferentes ángulos. Pro Tip Combinado: Role Playing + Emotional Prompting es devastador:

Eres un abogado corporativo con 15 años de experiencia en M&A.

Esto es crítico: estamos a 48 horas de firmar una adquisición de $2M.

Revisa este term sheet como si tu licencia dependiera de ello.

¿Qué cláusulas me matarían en 12 meses?

Referencias y Recursos Adicionales

Papers Fundamentales

- "Chain-of-Thought Prompting Elicits Reasoning in Large Language Models" – Wei et al., Google Brain, 2022

- "Constitutional AI: Harmlessness from AI Feedback" – Bai et al., Anthropic, 2022

- "Tree of Thoughts: Deliberate Problem Solving with Large Language Models" – Yao et al., Princeton/Google, 2023

- "EmotionPrompt: Large Language Models Understand and Can Be Enhanced by Emotional Stimuli" – Li et al., Microsoft Research, 2023 (Estudio sobre Emotional Prompting)

Líderes de Opinión a Seguir

- Ethan Mollick (Wharton): Blog sobre IA práctica en negocios

- Simon Willison: Blog técnico, creador de Datasette, pionero en prompting

- Lilian Weng (OpenAI): Blog sobre arquitectura de LLMs

- Riley Goodside (Scale AI): Referencia esencial en Twitter para ingeniería de prompts

Herramientas para Practicar

- OpenAI Playground: Experimenta con temperatura/top-p

- Anthropic Console: Ideal para prompts largos y estructurados

- PromptPerfect: Optimizador automático de prompts

- LearnPrompting.org: Curso estructurado gratuito